최근 인공지능이 언어와 시각 정보를 이해하는 능력에서 비약적인 발전을 이루면서, 로봇이 인간의 고차원적 지시를 이해하고 실제 물리적 세계에서 물체를 조작하거나 공간을 이동하는 동작을 수행할 수 있는 Physical AI에 대한 관심이 높아지고 있다. 이는 대형 언어모델(LLM), 비전-언어 모델(VLM), 강화학습(RL), 로봇 제어 기술이 융합된 분야로, 차세대 지능형 로봇의 핵심 기반이 될 것으로 기대된다.

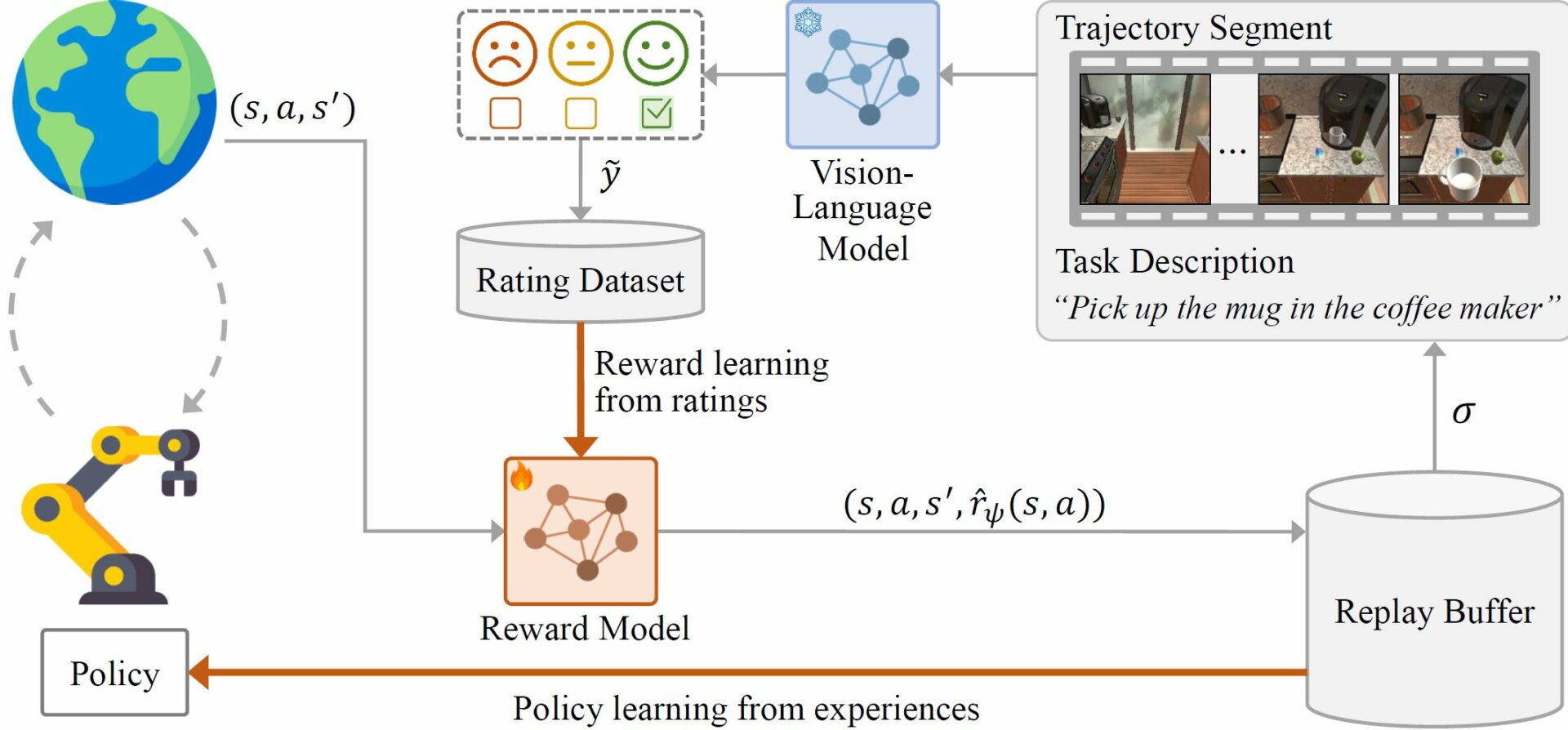

우리 학부 유창동 교수 연구팀(U-AIM: Artificial Intelligence & Machine Learning Lab)은 이러한 Physical AI의 비전을 실현하기 위해, 대형 비전-언어 모델을 활용한 새로운 두 가지 강화학습 프레임워크를 개발하였다. 첫 번째는 ICML 2025에 게재된 ‘ERL-VLM(Enhancing Rating-based Learning to Effectively Leverage Feedback from Vision-Language Models)’으로 대형 비전-언어 모델이 제공하는 절대 등급 피드백을 이용해 보상함수를 학습하고 이를 통해 로봇 제어 인공지능 모델을 학습한다. 이 접근은 기존의 복잡한 강화학습 보상 설계 과정을 제거하고, 대량의 피드백을 자동으로 얻을 수 있어 시간과 비용을 획기적으로 절감할 수 있다.

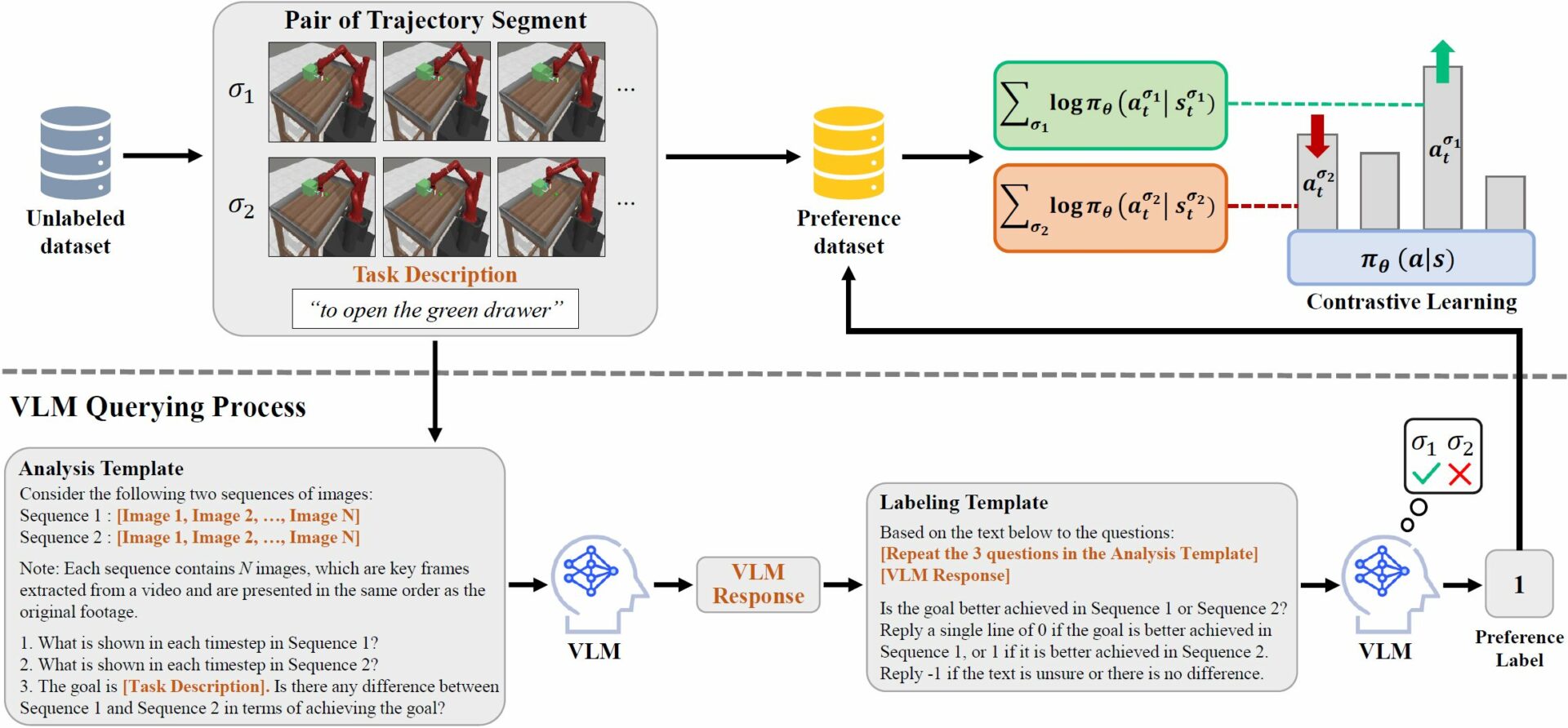

두 번째는 IROS 2025에 발표된 ‘PLARE(Preference-based Learning from Vision-Language Model without Reward Estimation)’로, 보상함수를 생략하고, 대형 비전-언어 모델이 제공하는 선호도 피드백만을 활용해 로봇 제어 인공지능 모델을 학습한다. 이 방식은 별도의 보상 모델을 만들 필요가 없기 때문에 학습 과정이 단순해지고 계산 자원 소모를 줄일 수 있다.

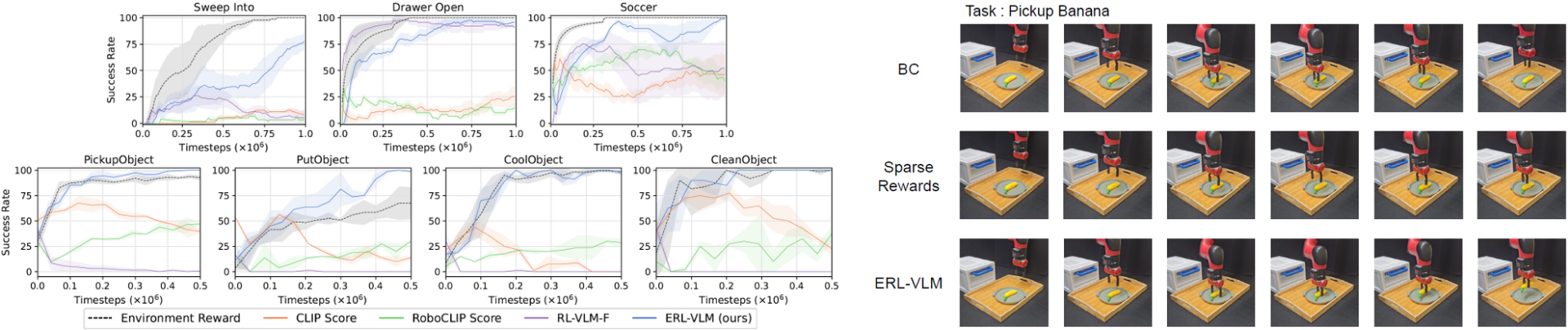

이 두 연구는 로봇 시뮬레이션 환경뿐만 아니라 실제 로봇을 이용한 실험에서도 기존 방식들보다 높은 성공률과 안정적인 성능을 보여주며, 실질적인 적용 가능성을 입증하였다.

이번 연구는 로봇이 인간의 언어를 이해하고 실제 행동으로 옮기는 과정을 대형 비전-언어 모델을 통해 보다 효율적이고 현실적인 방식으로 구현한 것으로 Physical AI 실현 가능성을 한층 가까이 보여주었다. 앞으로도 유창동 교수 연구팀은 로봇 제어, 시각-언어 기반 상호작용, 피드백 효율화 등 다양한 방향에서 Physical AI 관련 연구를 이어갈 예정이다.