우리학부 심현철교수 연구팀이 2021년 현대차그룹 자율주행 챌린지에서 우승을 차지하여 많은 언론에 보도되었습니다.

[심현철교수 사진]

심현철교수연구팀(팀명 : KI- ROBOTICS) 자율주행차가 29일 서울 상암동 MBC 광장 일대에서 열린 ‘2021 현대차그룹 자율주행 챌린지’에서 우승을 차지했다.

이번 대회는 예전과 달리 상암동 실제 도로에서 다른 참가팀 차들과 동시에 주행하는 방식으로 진행되어 실제 도로에서의 자율주행 기술에 더욱 다가섰다는데 큰 의의가 있다.

연구팀은 GPS(위성항법장치) 장치 없이 카메라와 라이다 센서만을 활용한 자율주행차로 1위를 기록해 주목을 받았다.

본대회 예선 23개팀 중 본선 6팀이 선발되었으며, 본선 우승한 심현철교수 연구팀에게는 상금 1억원과 북미 견학의 혜택이 주어진다.

심현철교수는 17개월간 이대규 전기및전자공학부 박사과정학생을 중심으로 대회를 준비하며, 국내 최초의 전기차기반 자율주행 챌린지에서 우승한 팀원들의 노력이 빛을 발했으며, 대회준비 및 우승경험이 향후 관련 기술 발전에 많은 기여를 할 것이라 전했다.

[2021 현대차그룹 자율주행 챌린지에서 우승을 차지한 KAIST’ 연구팀]

관련 링크 :

데일리카 : http://www.dailycar.co.kr/content/news.html?type=view&autoId=41811

한국경제신문 : https://www.hankyung.com/economy/article/202111291999g

전기및전자공학부 황의종 교수님 연구실 태기현 박사과정생이 정확하고 공정한 머신러닝 모델을 위한 선택적 데이터 수집 기법을 개발했습니다.

머신러닝이 현대 사회에 폭넓게 사용되면서 책임 있는 인공지능의 필요성이 대두되고 있습니다. 높은 정확도를 넘어서 책임 있는 인공지능의 목표에는 공정성(fairness), 강건성(robustness), 설명가능성(explainability) 등이 포함되어 있습니다. 특히, Google, Microsoft, IBM 등의 회사에서 책임있는 인공지능을 강조하고 있습니다.

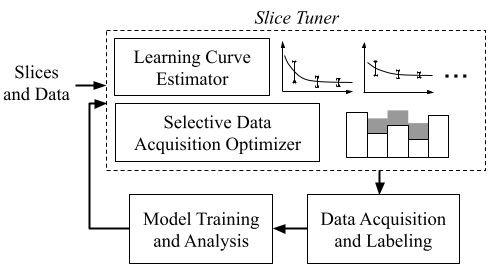

본 연구에서는 인공지능 공정성에 초점을 맞추고 불공정한 인공지능의 근원이 편향된 훈련 데이터에 있다는 점에 착안하여, 데이터 수집 단계에서부터 인공지능 모델의 정확도와 공정성을 함께 고려한 프레임워크인 Slice Tuner를 제안하였습니다. Slice Tuner는 데이터양에 따라 모델의 손실을 추정할 수 있는 학습 곡선(learning curve)을 효율적이고 신뢰할 수 있도록 관리하고, 이를 활용하여 정확하고 공정한 모델을 위한 최적의 데이터 수집 방법을 제시합니다.

연구팀은 해당 기술이 데이터 수집단계에서 부터 책임 있는 인공지능을 실현하기 위한 중요한 첫 단추가 될 수 있다고 설명했습니다. 또한, 본 연구 성과는 데이터베이스 최고 권위 학회인 ACM SIGMOD (International Conference on Management of Data) 2021 에서 발표되었습니다.

자세한 연구 내용은 하단의 링크에서 확인하실 수 있습니다.

Figure 1. Slice Tuner architecture

[논문 정보]

논문명: Slice Tuner: A Selective Data Acquisition Framework for Accurate and Fair Machine Learning Models

저자: 태기현, 황의종(지도교수)

논문 링크: https://arxiv.org/abs/2003.04549

논문 슬라이드: https://docs.google.com/presentation/d/1thnn2rEvTtcCbJc8s3TnHQ2IEDBsZOe66-o-u4Wb3y8/edit?usp=sharing

학회 발표 영상: https://youtu.be/QYEhURcd4u4?list=PL3xUNnH4TdbsfndCMn02BqAAgGB0z7cwq

전기및전자공학부 황의종 교수님과 서창호 교수님 연구팀에서 공정한 머신러닝 모델 학습을 위한 새로운 배치 선택 기법을 개발했습니다. 본 연구는 노유지 박사과정(지도교수 황의종)이 주저자로 참여했고, 위스콘신 매디슨 전기컴퓨터공학부 이강욱 교수님과의 공동 연구로 진행되었습니다.

인공지능 기술이 인간에게 단순히 편리성을 가져다주던 단계에서, 이제는 사회 전반에 걸쳐 광범위하게 활용되며 인간의 삶에 많은 영향을 미치고 있습니다. 최근 인공지능의 긍정적인 효과 이면에 머신러닝 모델이 특정 개인 혹은 집단을 차별하는 사례가 다수 발견되었고, 이에 따라 공정성(fairness)을 고려한 머신러닝 학습의 필요성에 대한 사회적인 공감이 커지고 있습니다.

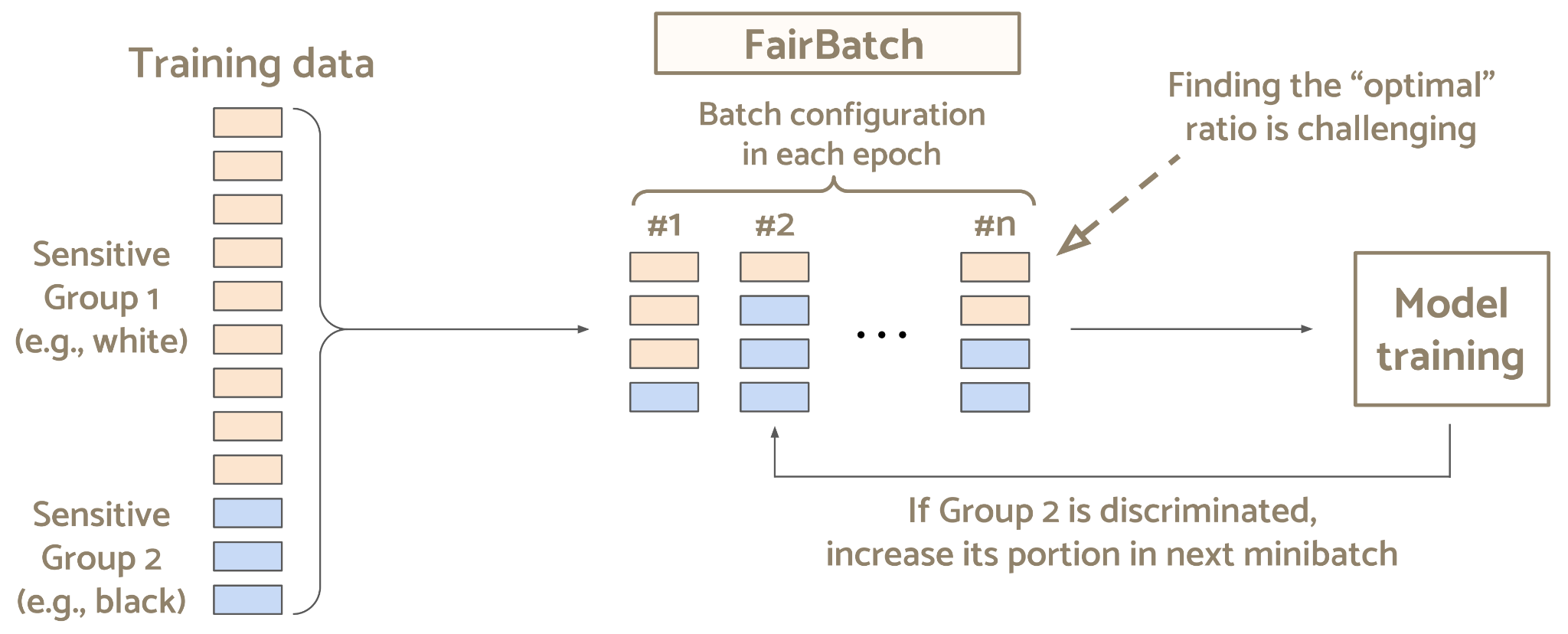

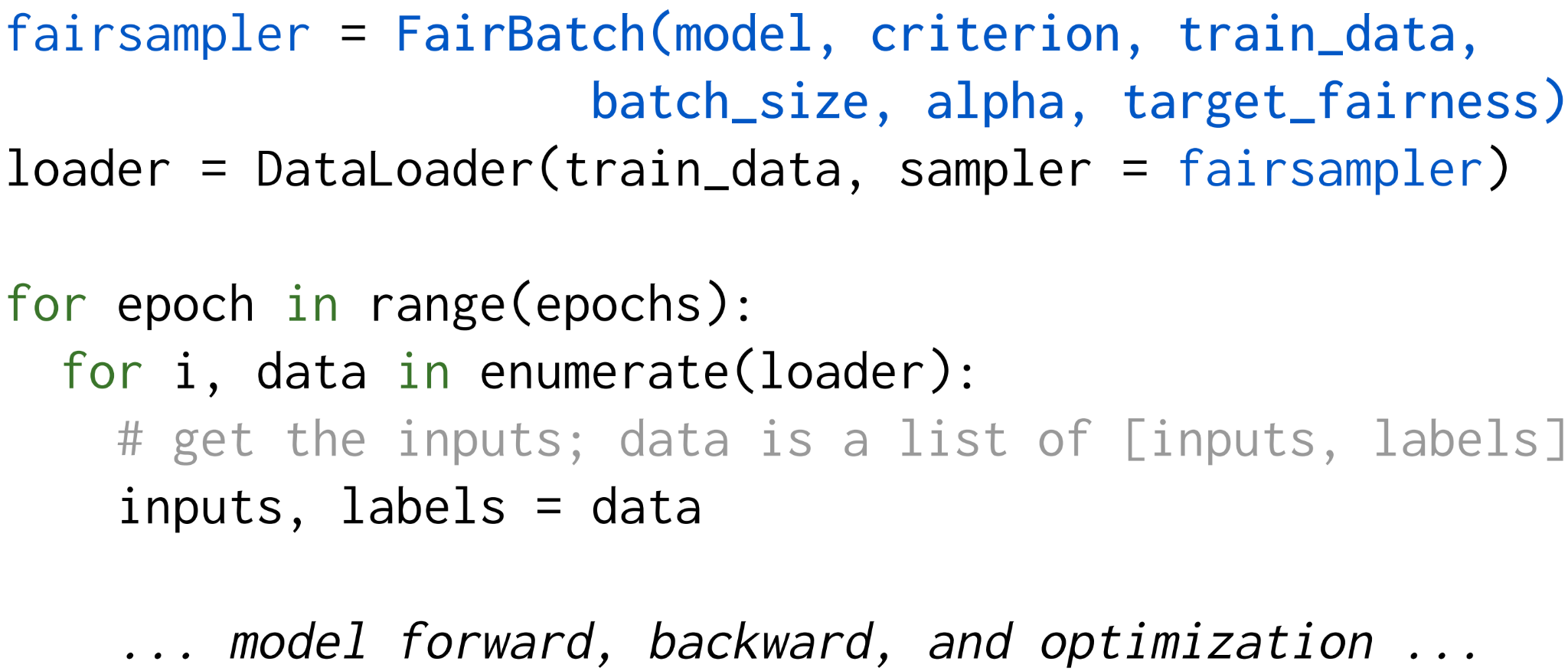

본 연구팀은 공정한 머신러닝 모델 학습을 위한 새로운 배치 선택(batch selection) 기법인 FairBatch를 제안합니다. 기존의 공정성을 위한 머신러닝 기법들은 학습 데이터 혹은 알고리즘 자체에 큰 수정이 요구되었는데, 이와는 달리 FairBatch는 데이터를 샘플링하는 배치 선택 단계에서 한 줄의 코드 변경만으로 높은 정확도와 공정성을 효과적으로 달성합니다. 또한 FairBatch는 이중수준 최적화를 통한 해석을 기반으로 하며, 다양한 시나리오에서 폭 넓게 활용이 가능함을 보였습니다.

연구팀은 FairBatch가 높은 성능을 달성함과 동시에 실제 머신러닝 파이프라인에 쉽게 적용될 수 있다는 장점을 가졌기에, 해당 학습 기법을 다양한 어플리케이션에 적용할 수 있을 것이라고 설명했습니다. 또한 공정한 머신러닝 시스템에 대한 사회적 요구가 더욱 커짐에 따라, 이에 대한 활발한 후속 연구가 진행될 것으로 예상됩니다. 본 연구 성과는 머신러닝 최고 권위 학회인 ICLR (International Conference for Learning Representations) 2021에서 발표되었습니다.

자세한 연구 내용은 하단의 링크에서 확인하실 수 있습니다.

Figure 1. A scenario that shows how FairBatch adaptively adjusts batch ratios in model training for fairness.

Figure 2. PyTorch code for model training where FairBatch is used for batch selection. Only a single-line code change is required to replace an existing sampler with FairBatch, marked in blue.

Title: FairBatch: Batch Selection for Model Fairness

Authors: Yuji Roh (KAIST EE), Kangwook Lee (Wisconsin-Madison Electrical & Computer Engineering), Steven Euijong Whang (KAIST EE), and Changho Suh (KAIST EE)

Paper: https://openreview.net/forum?id=YNnpaAKeCfx

Source code: https://github.com/yuji-roh/fairbatch

Slides: https://docs.google.com/presentation/d/1IfaYovisZUYxyofhdrgTYzHGXIwixK9EyoAsoE1YX-w/edit?usp=sharing

SW컴퓨팅산업원천기술개발사업

정명수 교수 연구팀 2021 년도 SW컴퓨팅산업원천기술개발사업 신규 선정

우리 학부 정명수 교수 연구팀이 제안한 “초연결사회를 위한 ICT향 지능형 스토리지 시스템”이 과학기술정보통신부와 정보통신기획평가원(IITP)이 주관하는 SW컴퓨팅산업원천기술개발 사업공모에서 신규 지원 대상으로 선정되었다. 정명수 교수 연구팀은 본 과제에서 단독으로 4년간 총 16억원의 연구비 지원을 받게 되었다.

제안하는 과제는 머신러닝을 통해 자율주행차량의 장애 예방 및 수명 연장에 핵심적인 스토리지 시스템의 신뢰성을 강화하는 내용을 담고 있다. 연구진은 본 연구에서 머신러닝 알고리즘, 하드웨어 자동화 기술, 스토리지 아키텍처를 아우르는 통합적인 기술을 개발할 것이다. IITP는 과제 선정 배경에 본 과제를 통해 국제 수준의 지능형 스토리지 원천기술 확보가 가능할 것으로 판단했다고 밝혔다.우리 학부 정명수 교수 연구팀이 제안한 “초연결사회를 위한 ICT향 지능형 스토리지 시스템”이 과학기술정보통신부와 정보통신기획평가원(IITP)이 주관하는 SW컴퓨팅산업원천기술개발 사업공모에서 신규 지원 대상으로 선정되었다. 정명수 교수 연구팀은 본 과제에서 단독으로 4년간 총 16억원의 연구비 지원을 받게 되었다.

IITP는 SW컴퓨팅산업원기술개발사업을 통해 미래 SW 기술을 주도할 유망분야에 대하여 SW의 지능화, 고성능화에 필요한 세계적 수준의 SW 원천핵심기술개발을 지원하고 있다.

이상원, 박규영, 정명수 (지도교수)

12th USENIX Workshop on Hot Topics in Storage and File Systems (HotStorage), 2020, Poster

https://www.usenix.org/conference/hotstorage20/presentation/lee

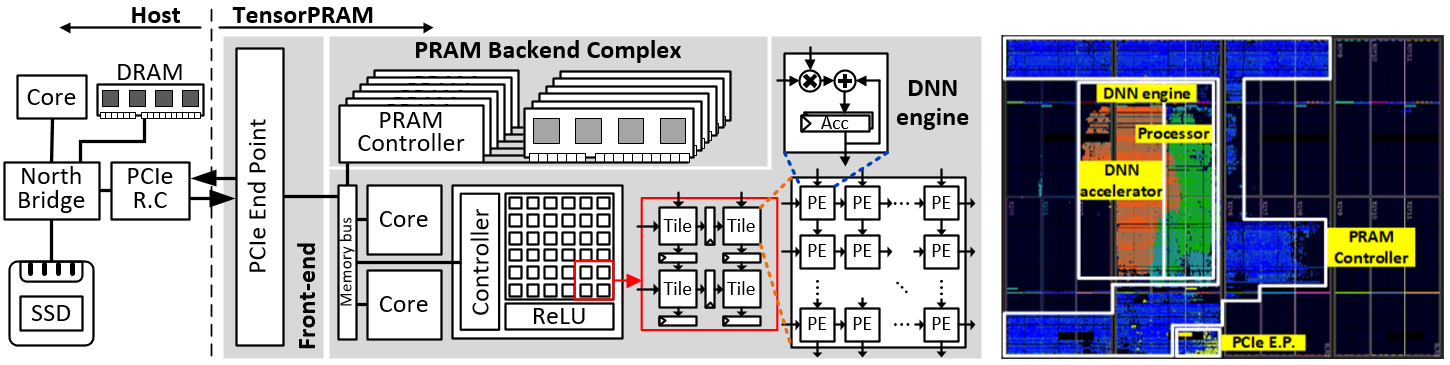

본 연구진은 확장 가능한 심층학습 가속기인 TensorPRAM을 제안한다. 이 가속기는 심층학습 연산을 수행하기 위한 연산 배열 형태로 구성할 수 있다. TensorPRAM은 행렬 곱셈 및 합성곱 연산을 수행할 수 있는 시스톨릭 배열 가속기를 포함하고 있다. 또한, 호스트와 가속기간 불필요한 데이터 이동을 줄이기 위해 TensorPRAM의 메모리를 바이트 단위 입출력이 가능한 비휘발성 메모리인 PRAM으로 대체하였다. 단일 FPGA 보드에 범용 프로세서, PCIe, PRAM 컨트롤러 및 시스톨릭 배열을 넣어 TensorPRAM prototype을 구현하였으며, PCIe 버스에 여러 개의 TensorPRAM을 연결하여 확장 가능하도록 구성하였다. 실제 시스템에서 평가한 결과, 다양한 DNN 워크로드에서 범용 프로세서 기반 가속기 및 시스톨릭 배열 기반 가속기 대비 평균 99%, 48% 빠른 연산 성능을 보였다.

그림1. 시스템 개요

장준혁, 국동현, 신진우 (AI대학원 석좌교수), 정명수 (지도교수)

12th USENIX Workshop on Hot Topics in Storage and File Systems (HotStorage), 2020, Poster

https://www.usenix.org/conference/hotstorage20/presentation/jang

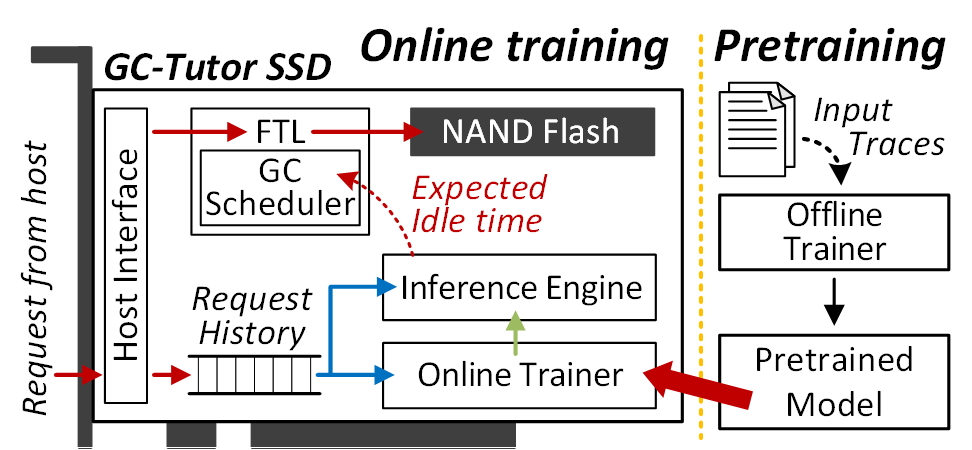

가비지 컬렉션(GC)은 솔리드 스테이드 드라이브(SSD)의 성능이 저하되는 주 요인 중 하나이다. 따라서 학계 및 산업계에서는 GC로 인한 성능 저하를 줄이기 위해 노력해왔다. 이를 위한 한가지 방식으로, 사용자가 SSD를 사용하지 않는 유휴 시간에 GC를 수행하고자 하는 연구들이 있었다. 백그라운드 GC라 불리는 이 기법은 큰 성능 개선을 얻을 수 있으나, 사용자가 SSD에 요청을 보내는 시점을 예측하기 어렵다는 새로운 문제점이 발생한다.

본 연구진은 심층학습 알고리즘을 사용하여 다음 입출력 요청이 오는 시간을 예측하고, 이를 통해 얻은 정확한 유휴시간을 기반으로 백그라운드 GC를 수행하여 사용자가 GC로 인한 성능 저하를 경험할 수 없도록 하는 새로운 GC 스케줄링 기법을 제안한다. 한편, 기존 DNN알고리즘은 학습하는데 수 십 시간에서 수 일이 걸리기 때문에 가변적인 입출력 요청 도착 시간 패턴의 예측에 적용하기 어렵다. 이를 위해, 본 연구진은 SSD에서 실시간으로 수집된 적은 양의 데이터로 DNN을 학습할 수 있는 가벼운 온라인 학습 알고리즘을 적용하여, 실시간으로 변하는 입출력 패턴을 SSD 내에서 언제나 높은 정확도로 예측할 수 있도록 했다. 제안된 GC스케줄러를 사용했을 때, 기존 알고리즘과 DNN기반 알고리즘에 비해 입출력 요청의 처리지연시간이 각각 82.4%, 67.9% 감소하였으며, 다양한 워크로드에서 DNN기반 알고리즘에 비해 16.9% 높은 예측 정확도를 보였다.

그림1. 시스템 개요

그림2. 고정된 모델과 온라인 학습이 적용된 모델의 예측 정확도 비교

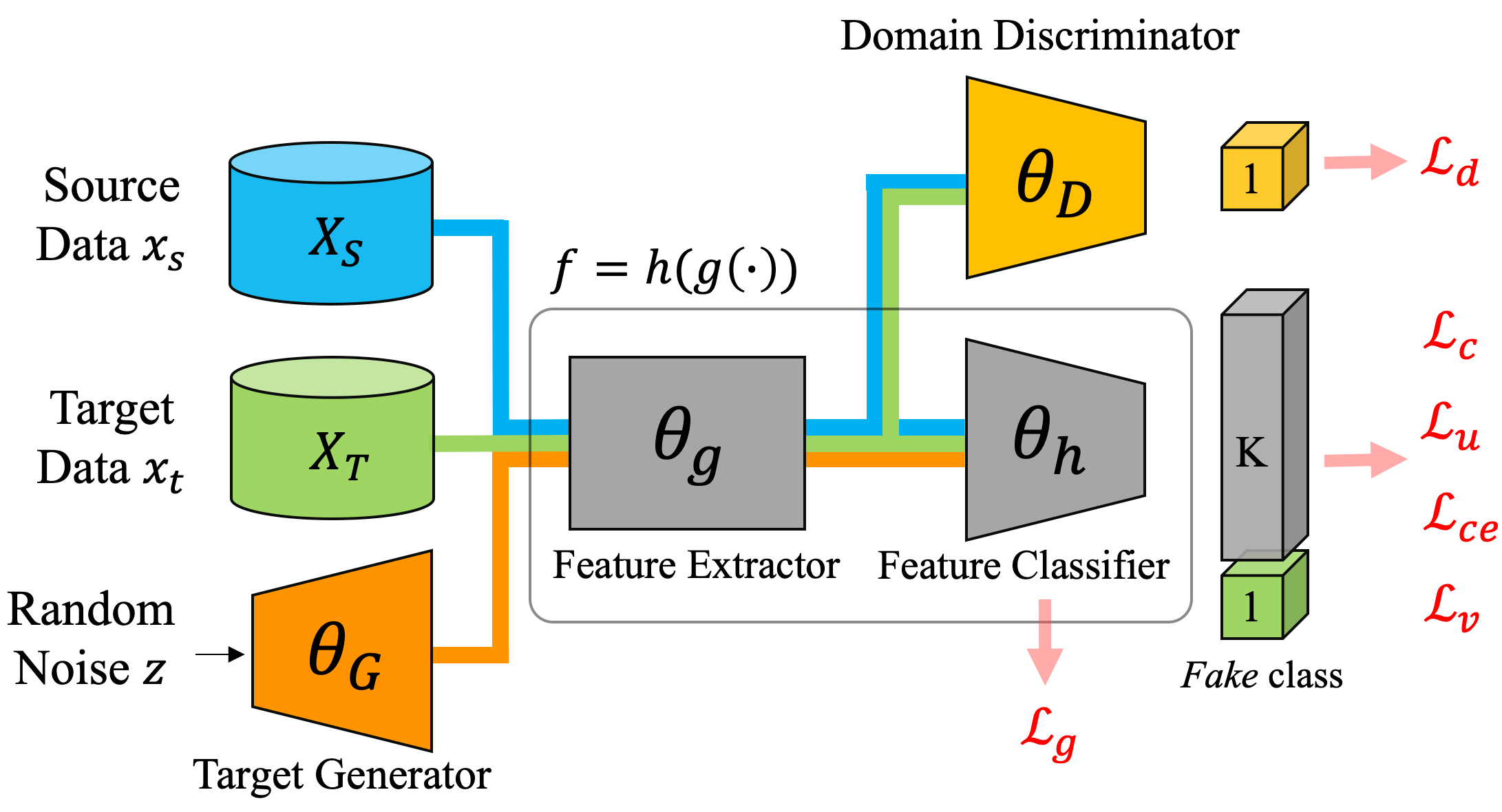

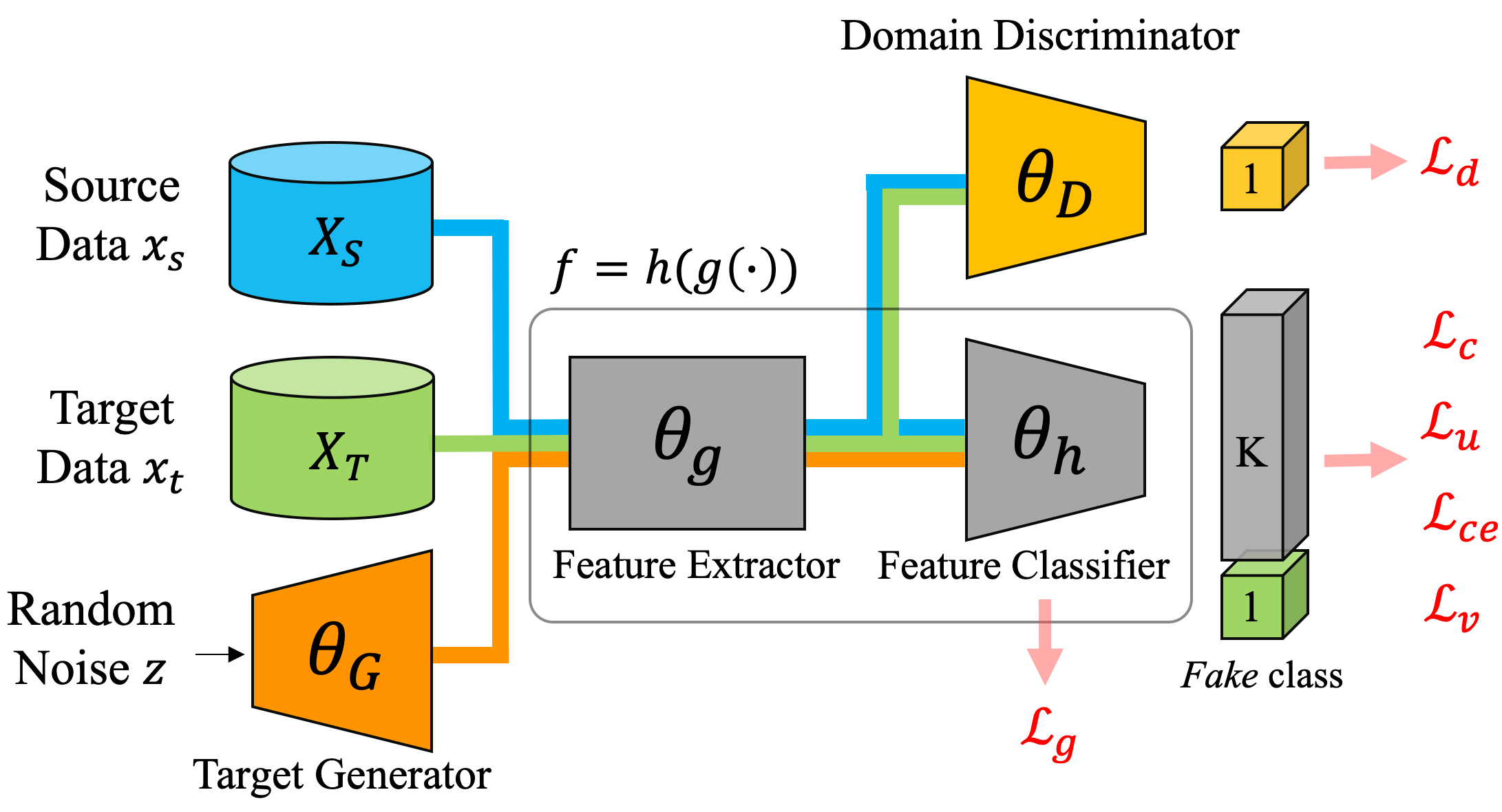

본 연구는 레이블이 존재하는 소스 도메인 데이터와 레이블이 없는 타깃 도메인 데이터를 활용하여 타깃 도메인에 대한 예측 모델을 얻는 것을 목표로 하는 비지도 학습 도메인 어댑테이션 문제를 해결한다.

최근, 양쪽의 도메인에 대해 불변한 특징 및 타깃 도메인에서 클래스별로 차별성이 높은 특징들을 추출하는 아이디어를 기반으로 한 연구들이 많이 제안되어왔고, 본 연구는 새로운 인공 클래스를 추가하고 GAN으로부터 생성된 인공 클래스의 샘플과 함께 학습 데이터에 대한 모델을 훈련함으로써 도메인에 대한 차별성을 향상하는 방법을 제안한다.

새로운 클래스 샘플을 기반으로 훈련된 모델은 타깃 도메인에서 클래스의 데이터를 재배치하여 특성 공간에서 대상 클러스터 사이의 거리를 늘림으로써보다 차별적인 특성을 추출 할 수 있다.

본 연구에서 제안하는 방법은 일반적인 방법론이므로 DANN, VADA 및 DIRT-T와 같은 기존의 많은 방법과 호환이 가능하며 비지도 도메인 어댑테이션 성능 평가에 사용되는 표준 데이터를 사용한 다양한 실험을 통해 본 연구에서 제안한 방법이 기존 연구 대비 가장 높은 성능을 냄을 확인하였다.

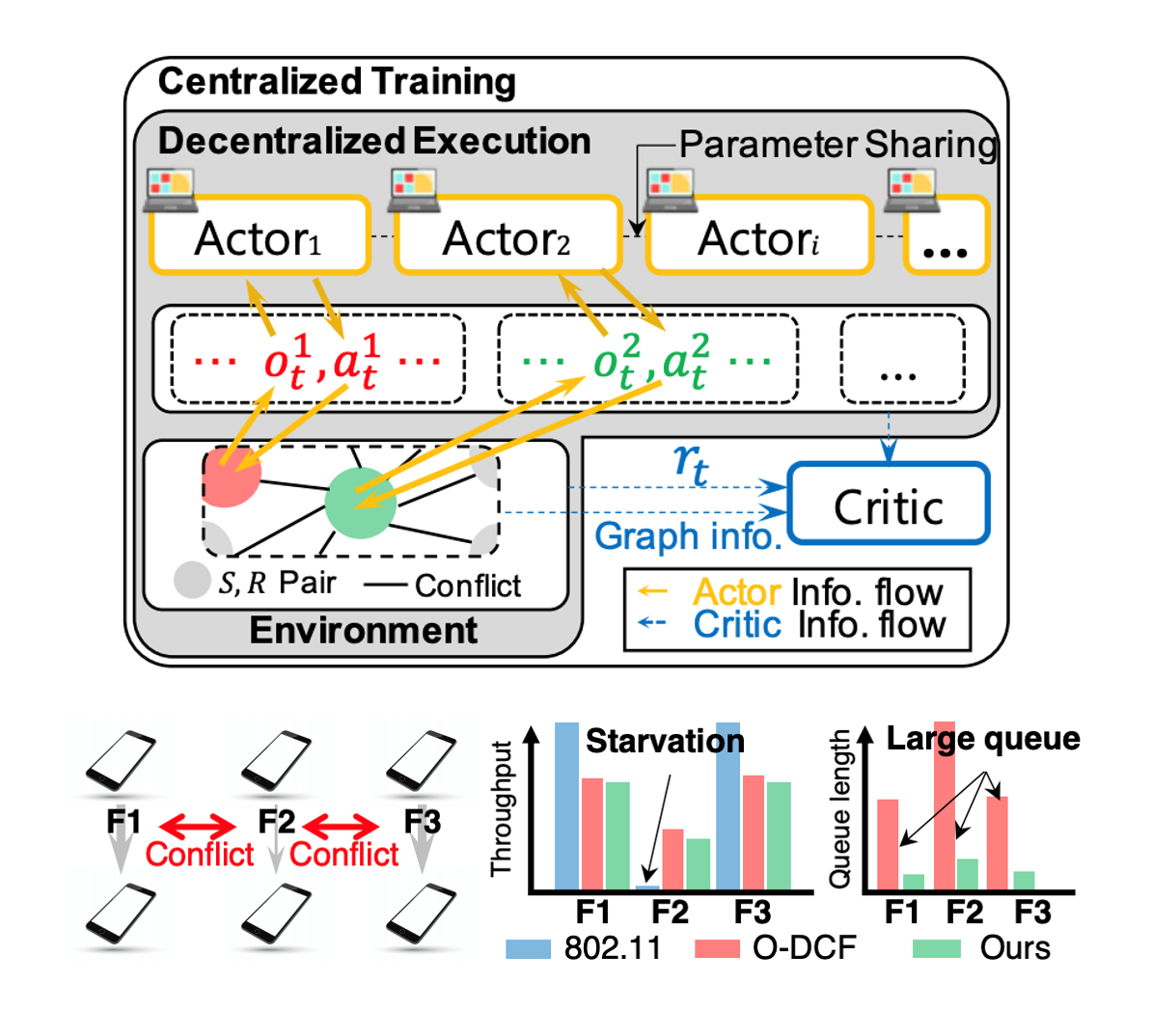

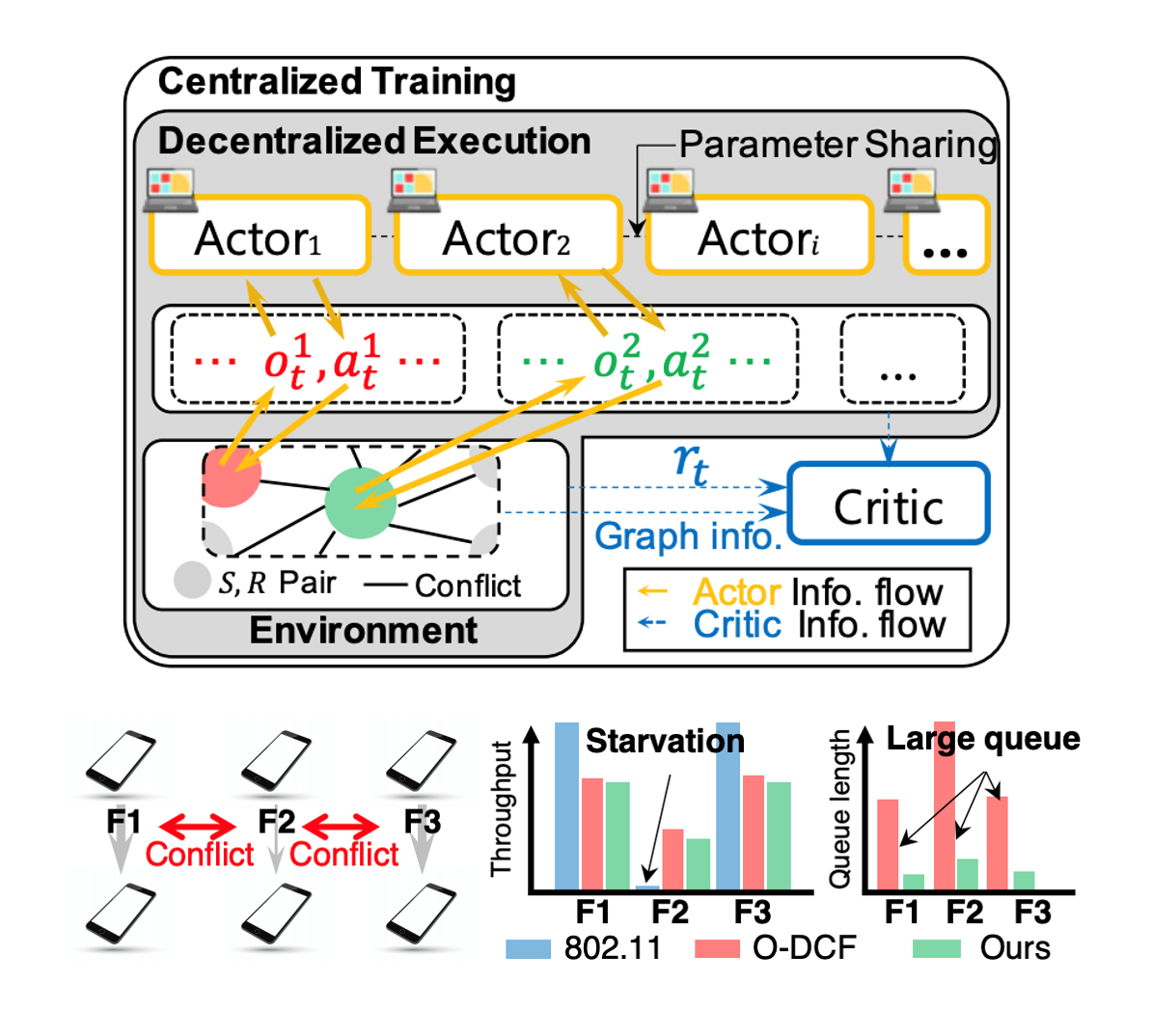

채널 감지 다중 접근 (CSMA) 알고리즘은 단순성과 일반성에 근거하여 표준 802.11 구현의 무선 매체 접근 제어 (MAC) 기법으로 사용되었다. CSMA 에 대한 연구는 실용적인 프로토콜로서도, 최적의 MAC 스케줄링을 달성하기 위한 분산적인 기법으로서도 광범위하게 이루어졌다. 하지만, 현재 개발되어 있는 가장 최신의 CSMA 기법 조차도 특정 상황, 특히 다중 홉 통신 환경 등에서 취약한 성능을 보인다. 이러한 성능의 개선을 위해 연구된 기법들은 지엽적인 상황에 대한 성능 보완을 하는 형식의 기법들이고, 모든 무선 통신 상황을 위한 범용성이 떨어지는 경향을 보인다. 본 논문에서는, 현재 새로운 제어 패러다임으로 대두되는 경험 기반 접근 방식에 근거하여, 심층 강화 학습으로 CSMA-기반 무선 MAC 알고리즘을 학습시키는 기법을 제시한다. 본 논문에서 새롭게 소개하는 기법은 Neuro-DCF 로 명명되고, 이 기법에 대한 설명은 두 가지의 핵심 설계 목표에 기반한다. 설계 목표를 설명하자면, 학습 방식은 (i) 분산적인 제어기 동작을 위한 안정적인 훈련 기법어야 하고, (ii) 다양한 간섭 패턴과 무선 환경에 모두 적용 가능한 통합 학습 방식이어야 한다. 목표 (i) 를 위해 본 논문에서는 다중 에이전트 강화 학습 프레임워크를 적용하였고, 목표 (ii) 를 위해서는 그래프 신경망에 기반한 학습 구조를 제안한다. 제안된 Neuro-DCF 의 성능 검증을 위해 다양한 무선 간섭 환경에서 802.11 DCF 와 O-DCF 기법 등과 성능 비교를 제시한다. O-DCF 는 이론에 기반되어 설계된 최적 CSMA 기법이고, 이러한 기존 방식들에 비하여 Neuro-DCF 는 최적의 성능 지표 달성을 유지하면서 전송 지연 시간을 비약적으로 줄일 수 있었다. 저자는 본 논문에서 제안한 다중 에이전트 강화 학습 방식이 이러한 네트워크 제어기 학습 기법에 대한 연구에 기여하고, MAC 계층 이외의 다른 계층에서도 분산 제어 방식의 훈련을 위한 하나의 프레임워크로서 기능하기를 기대한다.

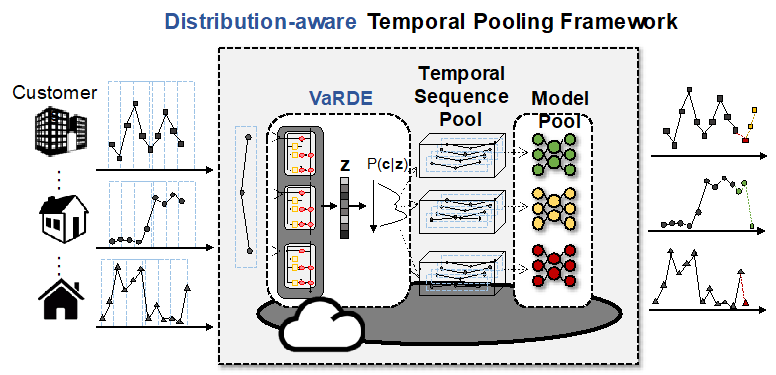

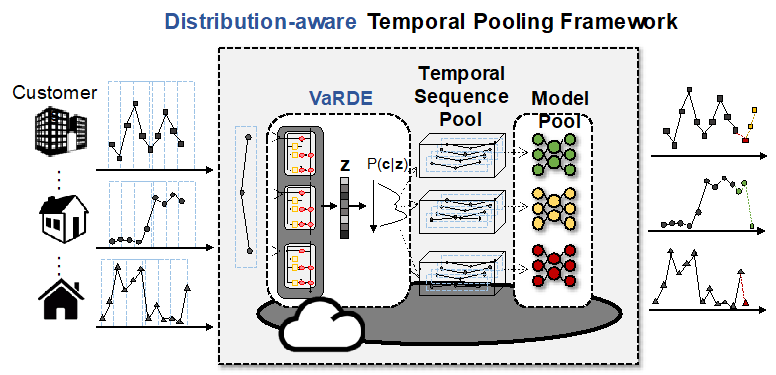

개별 부하 예측은 스마트 그리드 서비스를 위한 주요 컴포넌트 중 하나이다. 스마트 그리드의 엣지인 스마트 미터 들에서 계측된 데이터들은 실시간으로 클라우드 서버로 수집되고, 이를 기반으로 한 다양한 지능형 서비스를 제공하기 위해 각 스마트 미터 들의 장/단기 전력 소모량 예측이 수행된다. 서비스 제공자의 관점에서 중앙 서버에서 다중 계측기의 개별 부하 예측을 위한 모델을 학습할 때, 각 스마트 미터 들 간의 분포 격차에 대한 고려가 필요하다. 다중 고객들의 개별 예측을 처리하기 위한 방법으로 크게 두 가지 접근 방법이 수행되어 왔다:1) 각 고객별로 독립적 모델을 학습하거나 2) 다중 고객 정보들을 모두 포함할 수 있는 큰 모델을 학습 방식이 있다. 독립적인 방식은 후자보다 더 높은 정확도를 보이지만, 서비스 제공자의 관점에서 자원 및 관리 비 효율적이다. 반면 후자의 경우 그 반대로, 이 두 방식의 절충안인 클러스터링 기반의 예측 방식이 좋은 대안이 될 수 있다. 하지만, 기존의 클러스터링 기반 연구들의 경우 누적 부하에 초점을 맞추기 때문에 시간이 지남에 따라 분포 변화가 발생하는 개별 부하 예측의 개념 드리프트 문제를 고려하지 않는다는 점에서 한계가 있다. 이를 해결하기 위해 우리는 새로운 클러스터링 기반의 개별 부하 예측 프레임워크인 분포 인지형 시계열 풀링 기법 (Distribution-aware Temporal Pooling)을 제안한다. 클러스터링을 위해 VaRDE (Variational Recurrent Deep Embeding)를 제안하는데, 이는 시계열 데이터의 분포를 추정하는 형태로 클러스터링을 수행하기 때문에 높은 불규칙성을 갖는 개별 부하 예측 클러스터링에 적합하다. 뿐만 아니라, 전체 프레임워크는 모든 고객의 매 시점 데이터에 대해 클러스터를 할당하도록 동작하며, 매 시점의 시계열 데이터 분포를 추론하고 이를 바탕으로 클러스터링을 수행하기 때문에 고객의 데이터 분포가 시간에 따라 변하더라도 매 시점에 가장 적합한 예측 모델이 이를 처리하도록 한다. 우리는 실 AMI 데이터를 사용하여 제안 기법을 평가하였으며, 그 결과들은 제안 기법이 기존의 방식과 비교하여 우수한 성능을 가짐을 보여주었다. 그 뿐만 아니라, 본 기법은 학습에 사용되지 않은 새로운 스마트 미터 데이터에 대해서 역시 가장 우수한 성능을 보여주었으며, 이는 본 프레임워크가 중앙 서버에서 다중 고객을 처리하기에 높은 확장성을 가짐을 보여주었다.

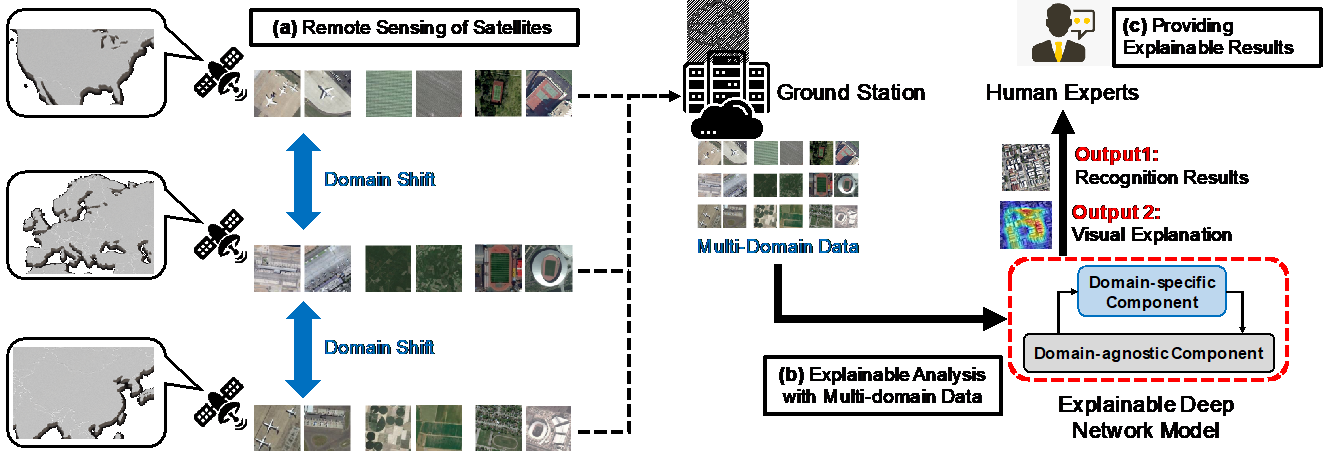

원격 탐사 기술의 발달과 함께, 위성 이미지는 환경 모니터링, 재해 예측 등 다양한 관련 분야에 활용되고 있다. 최근, 위성 이미지 분석에 있어서의 자동화 시도들이 활발히 진행되고 있으며, 이는 주로 합성곱 신경망을 기반으로 연구되고 있다. 하지만, 현재까지의 딥러닝 기반 위성 이미지 분석 시스템들을 실제로 적용하기 위해서는 다음 사항들이 해결되어야 한다. 먼저, 재해 예측 등의 많은 위성 이미지 분석 시스템들은 극단적으로 높은 정확도를 요구하며 해당 시스템의 잘못된 판단은 커다란 문제를 낳기 때문에, 해당 딥러닝 기반 시스템의 경우 신뢰성을 필수적으로 갖추어야 한다. 이는 즉, 딥 네트워크가 도출한 결과에 대한 설명가능성을 제공해야 함을 의미한다. 또한, 다수의 위성들로부터의 이미지들에 대한 분석을 다루는 경우, 그것들 사이의 도메인 이동을 고려하여 딥 네트워크에 대한 학습이 이루어져야 한다. 여기서, 도메인 이동은 주로 위성간 공간 해상도 등이 상이함으로 인하여 발생하며, 이러한 다중 도메인 이미지를 활용한 학습에서는 각각의 소스 도메인 모두에서의 정확도를 내기 위한 학습이 필요하다. 이를 해결하기 위하여 본 논문에서는 주의 집중 어뎁터 기반의 다중 도메인 학습 방법을 제안한다. 해당 어뎁터 모듈은 백본 네트워크의 플러그인으로써 동작하며, 도메인 고유 특징 추출 뿐만 아니라 입력 이미지에 대한 채널 및 공간 주의 집중을 개선하는 효과를 보인다. 이어 우리는 해당 백본 네트워크와 도메인 어뎁터의 대체 훈련 기법을 제시한다. 해당 기법에서의 학습은 백본 네트워크와 도메인 어뎁터가 번갈아가며 동결되는 방식으로 진행되며, 이는 효과적으로 도메인 고유 및 도메인 공통 특징을 효과적으로 분리할 수 있도록 한다. 마지막으로, 우리는 Grad-CAM 및 LIME을 사용하여 제안 네트워크 구조에서의 예측에 대한 설명을 제공한다. 성능 평가를 통하여, 제안된 방법들이 높은 다중 클래스 객체 인식 성능을 가질 뿐만 아니라, 개선된 설명 시각화 특성을 나타냄을 보인다.